Hội thảo trực tuyến “Creating world-class Al factories with NVIDIA Networking and Reference Architecture” do NVIDIA tổ chức vào cuối tháng 7 vừa qua là một sự kiện nhằm giới thiệu các giải pháp đột phá để xây dựng các trung tâm dữ liệu AI thế hệ mới. Sự kiện này sẽ đi sâu vào việc tại sao hệ thống mạng hiệu suất cao được thiết kế chuyên biệt lại là yếu tố then chốt để mở rộng quy mô AI.

Bối cảnh: AI tạo sinh và nhu cầu về Mạng hiệu suất cao

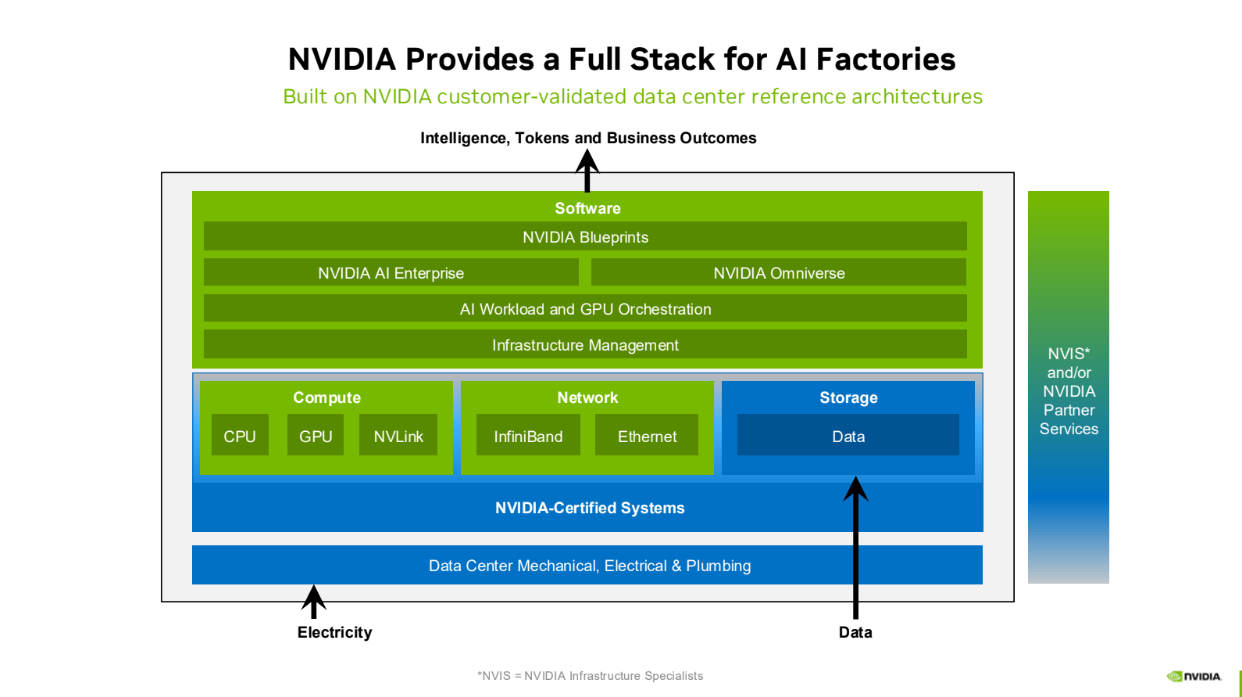

Trí tuệ nhân tạo tạo sinh (Generative AI) đang thay đổi mọi ngành công nghiệp, nhưng để các mô hình này phát triển, chúng cần một cơ sở hạ tầng có sức mạnh tính toán khổng lồ. Các trung tâm dữ liệu truyền thống không thể đáp ứng được.

Các mô hình AI lớn hoạt động theo kiểu điện toán phân tán (distributed computing) – nơi nhiều máy chủ và GPU phải làm việc cùng lúc, chia sẻ lượng dữ liệu khổng lồ qua mạng. Vấn đề là, hiệu suất của toàn bộ tác vụ AI lại bị giới hạn bởi nút chậm nhất trong mạng. Nếu mạng bị nghẽn, các GPU sẽ phải chờ đợi, gây lãng phí tài nguyên và năng lượng.

Đây là lý do tại sao các “Nhà máy AI” ra đời, yêu cầu một hệ thống mạng chuyên biệt, hiệu suất cao, đủ sức xử lý các luồng dữ liệu khổng lồ (“elephant flows”) mà không gây ra tắc nghẽn hay độ trễ cao.

Nền tảng Mạng cho AI: Mạng lossless và RDMA

Để đảm bảo các tác vụ AI chạy mượt mà, mạng phải đáp ứng hai yêu cầu cốt lõi:

Mạng Lossless: Các mạng truyền thống có thể làm mất gói dữ liệu, buộc hệ thống phải gửi lại, gây ra độ trễ. Một mạng lossless đảm bảo tất cả các gói dữ liệu đến đích chính xác, không bị hỏng hóc, giúp tối đa hóa hiệu suất của GPU.

RDMA (Remote Direct Memory Access): Đây là công nghệ cốt lõi giúp mạng đạt hiệu suất cao. RDMA cho phép truyền dữ liệu trực tiếp giữa bộ nhớ của các máy chủ và GPU mà không cần qua sự can thiệp của CPU, từ đó giảm đáng kể độ trễ và giải phóng tài nguyên hệ thống.

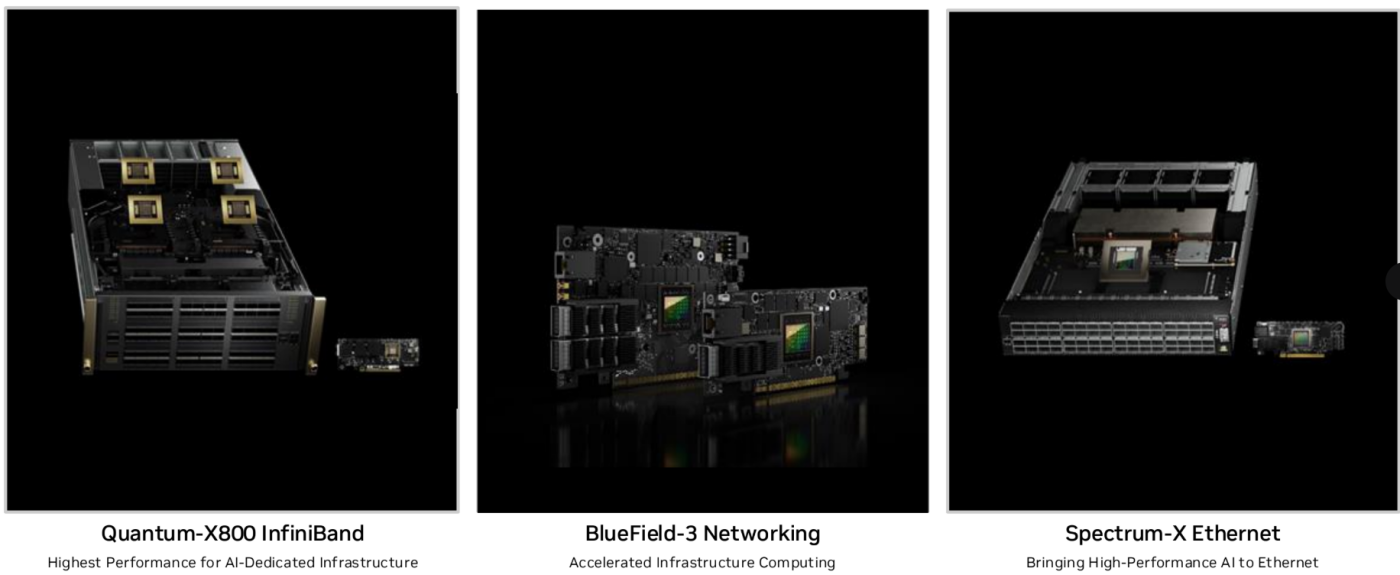

Giải pháp Mạng chuyên dụng của NVIDIA

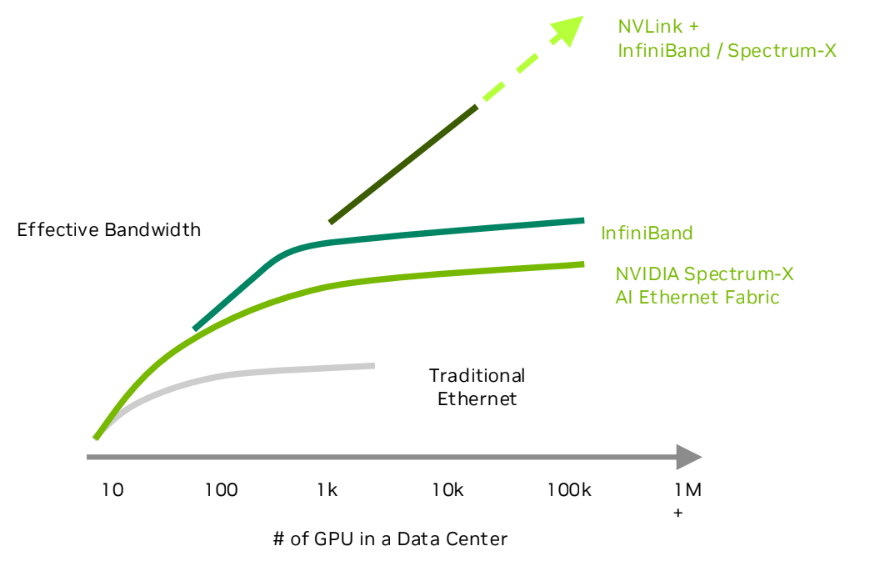

NVIDIA cung cấp hai nền tảng mạng hàng đầu, mỗi nền tảng được tối ưu hóa cho các nhu cầu AI cụ thể:

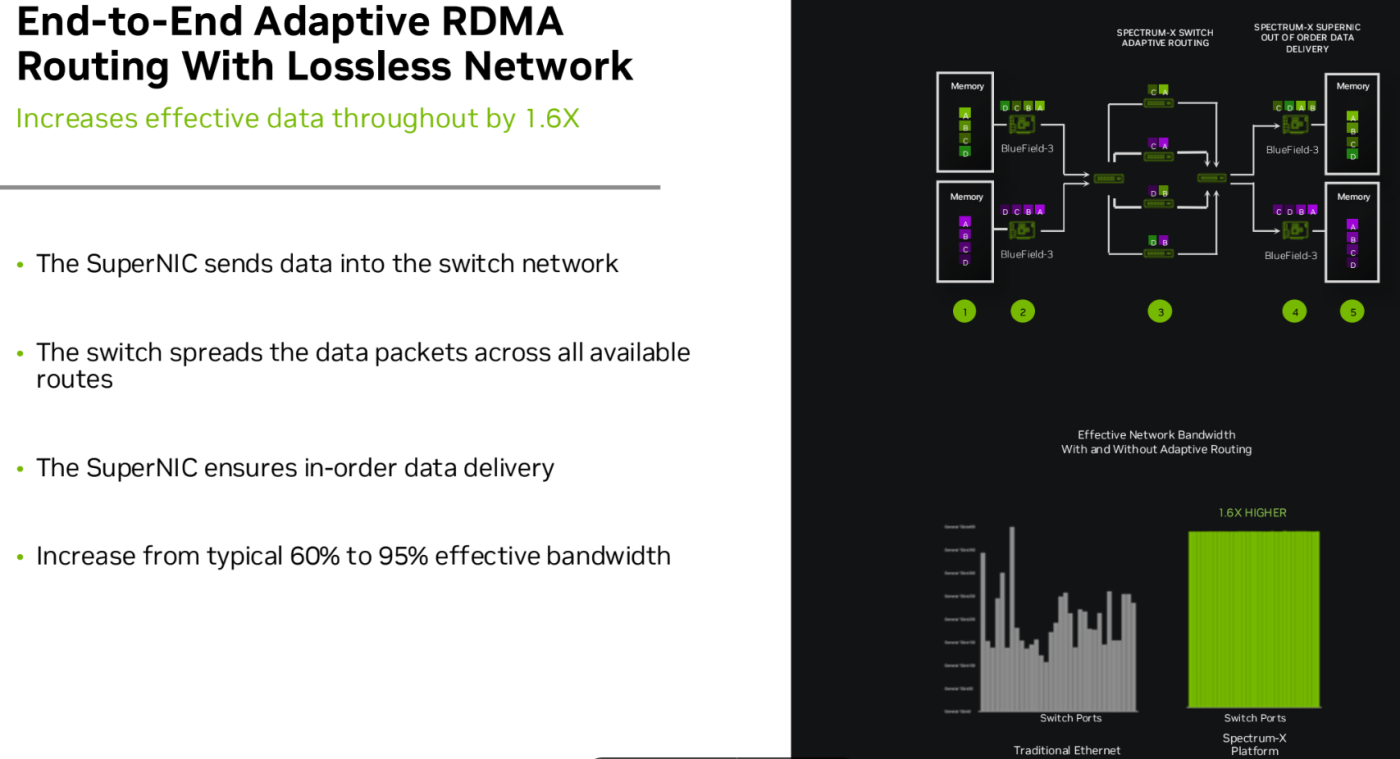

NVIDIA Spectrum-X Ethernet: Đây là giải pháp đột phá để xây dựng các đám mây AI đa khách thuê trên nền tảng Ethernet. Spectrum-X giải quyết các vấn đề tắc nghẽn thông qua:

- Định tuyến thích ứng (Adaptive Routing): Tự động phân tán lưu lượng dữ liệu qua mạng để cân bằng tải và tránh các điểm nghẽn.

- Kiểm soát tắc nghẽn (Congestion Control): Sử dụng dữ liệu đo từ xa được tăng tốc bằng phần cứng để chủ động điều chỉnh luồng dữ liệu, ngăn chặn tắc nghẽn trước khi chúng xảy ra.

NVIDIA Quantum InfiniBand: Đây là “tiêu chuẩn vàng” cho các hệ thống siêu máy tính (HPC) và các nhà máy AI quy mô lớn. InfiniBand cung cấp:

- In-Network Computing: Một khả năng độc đáo giúp thực hiện các phép tính trực tiếp trên mạng, giảm đáng kể lưu lượng dữ liệu.

- Công nghệ SHARP (Scalable Hierarchical Aggregation and Reduction Protocol) cho phép các switch thực hiện các phép toán tổng hợp, tăng gấp đôi băng thông hiệu quả.

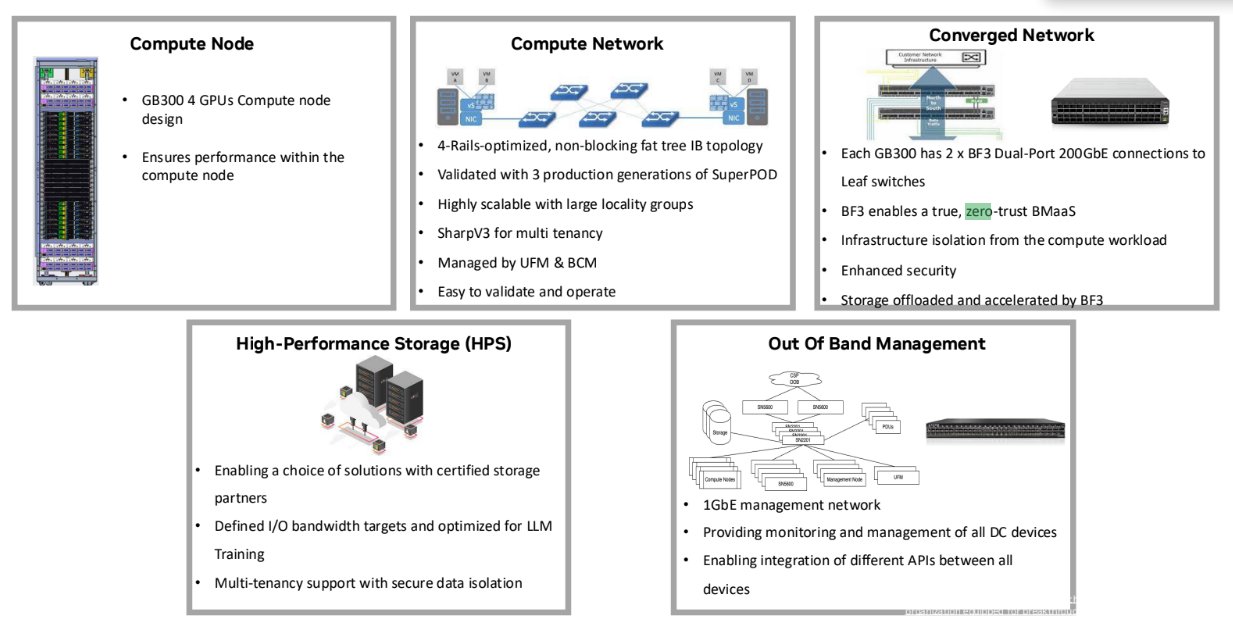

Kiến trúc tham chiếu và Bảo mật toàn diện

Để đảm bảo sự thành công của một dự án AI, việc tuân thủ Kiến trúc tham chiếu (Reference Architectures – RA) của NVIDIA là rất quan trọng. Các kiến trúc này cung cấp một bản thiết kế đã được kiểm chứng, đảm bảo hiệu suất, vận hành và tính sẵn sàng của hệ thống.

Ngoài ra, an ninh bảo mật cũng là một yếu tố không thể thiếu trong các môi trường đa khách thuê. NVIDIA giải quyết vấn đề này với một kiến trúc tin cậy Zero-trust, bao gồm:

Cô lập hiệu suất và an ninh: Sử dụng bộ đệm gói tin chung để đảm bảo hiệu suất mạng công bằng, ngăn chặn một tác vụ chiếm đoạt tài nguyên của các tác vụ khác.

Mã hóa dữ liệu: Các giải pháp của NVIDIA, đặc biệt là NVIDIA BlueField-3, hỗ trợ các tính năng bảo mật cấp độ phần cứng như khởi động an toàn (secure boot) và mã hóa dữ liệu khi truyền bằng các giao thức như MACsec và IPsec, đảm bảo an toàn cho dữ liệu trong toàn bộ trung tâm dữ liệu.

Hội thảo “Creating world-class Al factories with NVIDIA Networking and Reference Architecture” không chỉ là một sự kiện giới thiệu sản phẩm, mà còn là một cơ hội quý báu để những người làm việc trong lĩnh vực công nghệ hiểu rõ hơn về cách xây dựng nền tảng vững chắc cho tương lai của AI. Lợi ích mà hội thảo mang lại cho từng nhóm đối tượng cụ thể là rất rõ ràng:

Đối với chuyên gia Hạ tầng mạng: Hội thảo cung cấp một cái nhìn sâu sắc vào những thách thức của mạng truyền thống đối với các khối lượng công việc AI. Bạn sẽ được trang bị kiến thức chuyên môn về các công nghệ đột phá như Mạng Lossless, Định tuyến thích ứng và Kiểm soát tắc nghẽn, cũng như sự khác biệt giữa hai nền tảng mạng hàng đầu NVIDIA InfiniBand và NVIDIA Spectrum-X. Đây là cơ hội để học cách thiết kế một mạng không còn là “điểm nghẽn” mà trở thành động lực thúc đẩy hiệu suất AI.

Đối với người làm về AI (Kỹ sư, nhà khoa học dữ liệu): Bạn sẽ hiểu được mối liên kết chặt chẽ giữa hiệu suất mạng và thời gian đào tạo mô hình. Thay vì chỉ tập trung vào GPU, hội thảo giúp bạn nhận ra rằng một kiến trúc mạng được tối ưu hóa sẽ trực tiếp tăng hiệu suất sử dụng GPU, giảm thời gian chờ, và đẩy nhanh quá trình phát triển, thử nghiệm mô hình AI. Việc tuân thủ Kiến trúc tham chiếu (RA) sẽ giúp bạn tránh những rủi ro về hiệu suất, đảm bảo sự ổn định và khả năng mở rộng của dự án.

Đối với chuyên gia Bảo mật: Hội thảo này đặc biệt quan trọng trong việc nâng cao nhận thức về bảo mật trong kỷ nguyên AI Cloud. Bạn sẽ được giới thiệu về kiến trúc Zero-trust và các công nghệ bảo mật được tích hợp ngay trong phần cứng như NVIDIA BlueField-3, giúp mã hóa dữ liệu khi truyền và tạo ra một gốc tin cậy phần cứng. Đây là kiến thức cần thiết để bảo vệ các tài sản dữ liệu nhạy cảm trong môi trường đa khách thuê, nơi rủi ro luôn tiềm ẩn.

Tóm lại, hội thảo không chỉ cung cấp kiến thức toàn diện về cách xây dựng một “Nhà máy AI” từ A đến Z, mà còn là một diễn đàn để kết nối, chia sẻ kinh nghiệm và học hỏi những chiến lược tốt nhất để đảm bảo hiệu suất, khả năng mở rộng và an ninh cho các dự án AI của bạn trong tương lai.

Giảng viên Nguyễn Hoài Linh